Условная энтропия.

Теория информационных процессов и систем + доп.

Материалы в эбс

Если источники, А и В независимы, то Н (В |А) = Н (В), причем это оказывается наибольшим значением условной энтропии. Другими словами, сообщение источника, А не может повысить неопределенность сообщения источника В; оно может либо не оказать никакого влияния (если источники независимы), либо понизить энтропию В. Пусть источник, А порождает ансамбль Ма сообщений (аа, а2,…, аМа), источнике порождает… Читать ещё >

Условная энтропия. Теория информационных процессов и систем + доп. Материалы в эбс (реферат, курсовая, диплом, контрольная)

Найдем совместную энтропию сложной информационной системы (композиции А, В) в том случае, если их сообщения не являются независимыми, т. е. если на содержание сообщения В оказывает влияние сообщение А.

Например, сообщение о матче футбольных команд Комета и Ракета «Комета выиграла» полностью снимает неопределенность о том, как сыграла Ракета.

Другой пример: сообщение, А содержит информацию о мужчине (фамилию, имя, отчество, год рождения, место рождения, образование, домашние адрес и телефон), а сообщение В содержит аналогичную информацию о женщине — супруге упомянутого мужчины. Очевидно, что сообщение В частично содержит в себе информацию А, а именно: фамилию жены, ее домашний адрес и телефон, скорее всего совпадающие с фамилией, домашним адресом и телефоном мужа, а также вероятностную оценку ее года рождения, который скорее всего близок к году рождения мужа. Таким образом, сообщение В несет для нас меньше информации, чем сообщение А, и совместная информация двух сообщений не является простой суммой информаций отдельных сообщений.

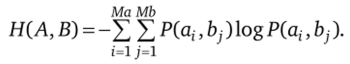

Пусть источник А порождает ансамбль Ма сообщений (аа, а2,…, аМа), источнике порождает ансамбль Mb сообщений (Ь2, Ь2,…, Ьдд,) и источники зависимы. Общий алфавит источников представляет собой множество пар вида (а, Ь;), общая мощность алфавита: Ма х Mb.

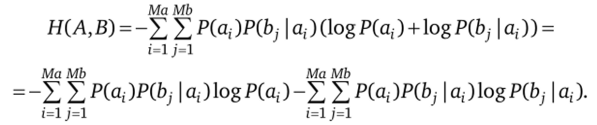

Энтропия сложной информационной системы (из двух источников) равна.

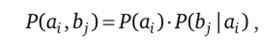

Поскольку А и В зависимы, то  а

а

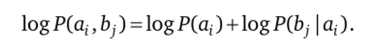

Подставив это в выражение для энтропии сложной системы, получаем:

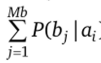

В первом слагаемом индекс j имеется только у В, изменив порядок суммирования, получим член вида  ), который равен 1, поскольку характеризует достоверное событие.

), который равен 1, поскольку характеризует достоверное событие.

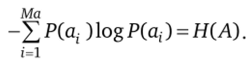

(какое-либо из сообщений в любом случае реализуется). Следовательно, первое слагаемое оказывается равным:

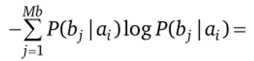

Во втором слагаемом члены вида

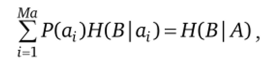

имеют смысл энтропии источника В при условии, что реализовалось сообщение а; — будем называть ее частной условной энтропией. Если ввести данное понятие и использовать его обозначение, то второе слагаемое будет иметь вид:

имеют смысл энтропии источника В при условии, что реализовалось сообщение а; — будем называть ее частной условной энтропией. Если ввести данное понятие и использовать его обозначение, то второе слагаемое будет иметь вид:

или подробнее.

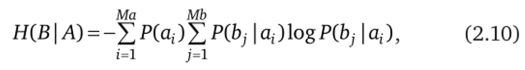

где Н (В |А) есть общая условная энтропия источника В относительно источника А. Окончательно получаем для энтропии сложной системы:

Полученное выражение представляет собой общее правило нахождения энтропии сложной системы. Совершенно очевидно, что выражение (2.9) является частным случаем (2.11) при условии независимости источников А и В.

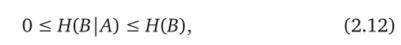

Относительно условной энтропии можно высказать следующие утверждения.

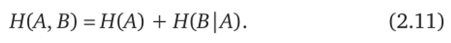

1. Условная энтропия является величиной неотрицательной. Причем Н (В |А) = 0 только в том случае, если любое сообщение А полностью определяет сообщение В, т. е.

В этом случае Н (А, В) = Н (А).

2. Если источники, А и В независимы, то Н (В |А) = Н (В), причем это оказывается наибольшим значением условной энтропии. Другими словами, сообщение источника, А не может повысить неопределенность сообщения источника В; оно может либо не оказать никакого влияния (если источники независимы), либо понизить энтропию В.

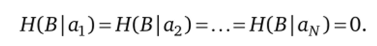

Приведенные утверждения можно объединить одним неравенством:

т.е. условная энтропия не превосходит безусловную.

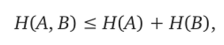

3. Из соотношений (2.11) и (2.12) следует, что.

причем равенство реализуется только в том случае, если источники, А и В независимы.

Энтропия источника непрерывных сообщений

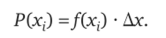

Рассмотрим систему, где качественные признаки состояния изменяются непрерывно (непрерывный сигнал). Вероятность нахождения системы в состоянии х (т.е. сигнал принимает значение х) характеризуется плотностью вероятности/(х). Чтобы найти энтропию такого сообщения, разбиваем диапазон возможного изменения сигнала на дискреты размером Дх. Вероятность нахождения системы в i-й дискрете равна.

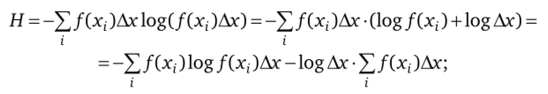

Тогда энтропия системы вычисляется так:

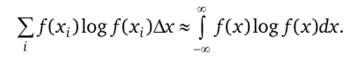

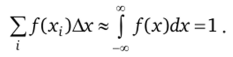

при малых Дх:

А также  Таким образом.

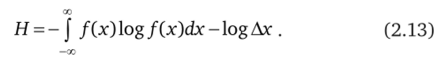

Таким образом.

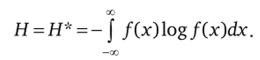

Положим, Дх = 1 (это возможно сделать, выбрав соответствующий масштаб и единицу измерения), тогда:

Величина Н* называется приведенной, или дифференциальной, энтропией.

При уменьшении Ах приведенная энтропия Я стремится к оо. Это естественно, так как чем точнее мы хотим задать состояние системы, тем большую степень неопределенности мы должны устранить. Дифференциальная энтропия не является мерой количества информации, хотя и характеризует степень неопределенности, присущую источнику.